前言

智能体刚出现的时候就很火爆,最近靠着MCP又是火爆了一把,以后肯定会越来越多的人去学习使用,不过作为AI小白的我还是要从基础的智能体开发开始学习,智能体开发平台有很多,大家可以自行上网搜索,我这里选择学习的是Dify,一是因为它免费且有社区,二是因为之前做项目对接过Dify的智能体API,从心理上对DIfy的接受度高一些。

Dify简介

Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使你是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

由于 Dify 内置了构建 LLM 应用所需的关键技术栈,包括对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎、稳健的 Agent 框架、灵活的流程编排,并同时提供了一套易用的界面和 API。这为开发者节省了许多重复造轮子的时间,使其可以专注在创新和业务需求上。

上面两段文字都是Dify官方技术文档上对它的解释,简而言之呢,就是一个简单、便携、易学易懂的一个低代码开发平台,可以帮助我们快速开发自己想要的智能体。

另外,本文以下内容都是根据官方文档给出的步骤/方法来进行实践的,如果觉得我说的啰嗦,可自行跳转到官方文档地址进行学习。

DIfy官方文档:https://docs.dify.ai/zh-hans

DIfy部署(社区版)

为什么要强调是社区版,聪明的小伙伴肯定能想到了,因为Dify有商业版,我用来学习的版本是社区版,也是开源版,有兴趣的小伙伴可以自行搜索(https://github.com/langgenius/dify)。

对于Dify的定价以及各个版本简介

Dify 提供灵活的定价方案,覆盖不同用户需求:

1. 云服务版

免费沙盒计划:包含 200 次免费 GPT-4 调用,适合个人或小型团队快速验证需求。

付费订阅:根据使用量阶梯计费,支持按需扩展,适合中大型企业或高频使用场景。

2. 私有化部署

社区版(开源):免费下载部署,适合技术团队自定义功能,但需自行维护服务器资源。

Premium 版:基于 AWS 的一键部署方案,支持数据私有化和企业级定制,适合对安全性要求高的客户。

3. 企业定制

企业服务支持:提供专属解决方案、API 调用优化及高级功能支持,需联系官方获取报价。

官网定价详情:https://dify.ai/pricing

以上内容引用自知乎老哥:Dify:开启低代码 AI 应用开发新纪元 - 知乎

正式部署(宝塔面板)

我本人因为最近时间紧张,所以使用几个部署方式中最懒人的方法,宝塔面板部署。

Dify支持的其他方式部署可参阅:https://docs.dify.ai/zh-hans/getting-started/install-self-hosted

不知道宝塔面板的小伙伴可跳转到 https://www.bt.cn/new/download.html

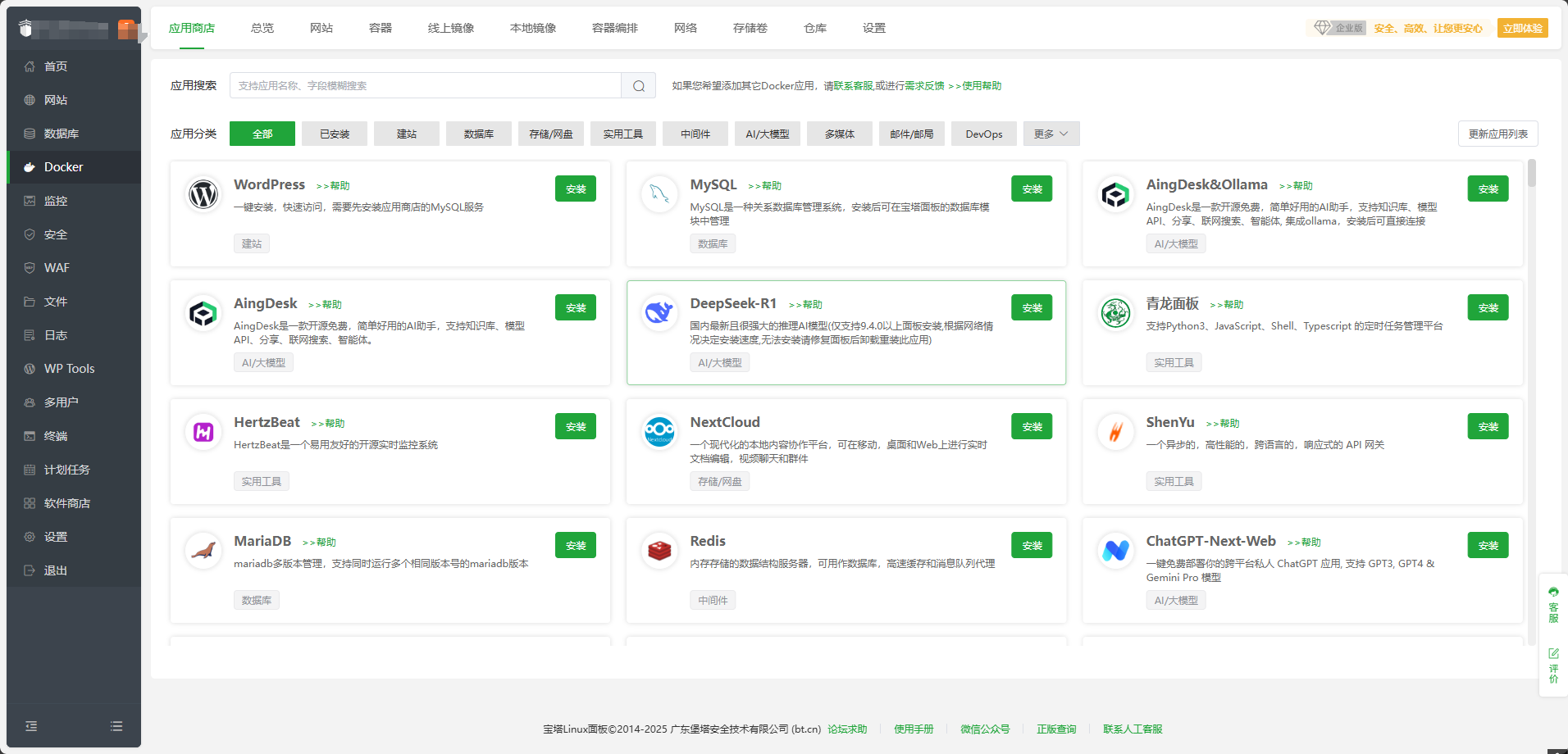

登录宝塔面板,在菜单栏中点击 Docker,根据提示安装 Docker 和 Docker Compose 服务

安装之后效果

在

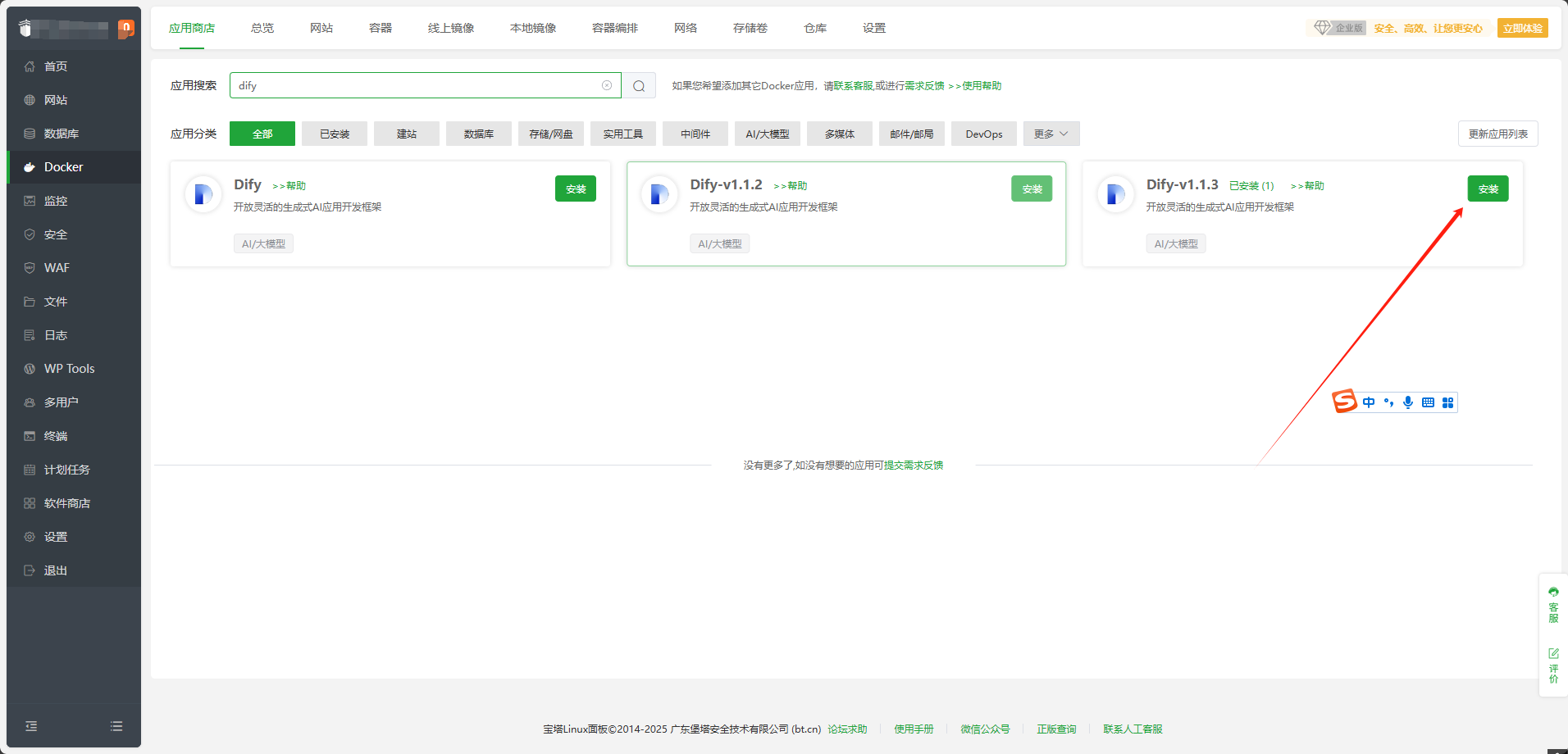

Docker-应用商店中找到Dify,点击安装

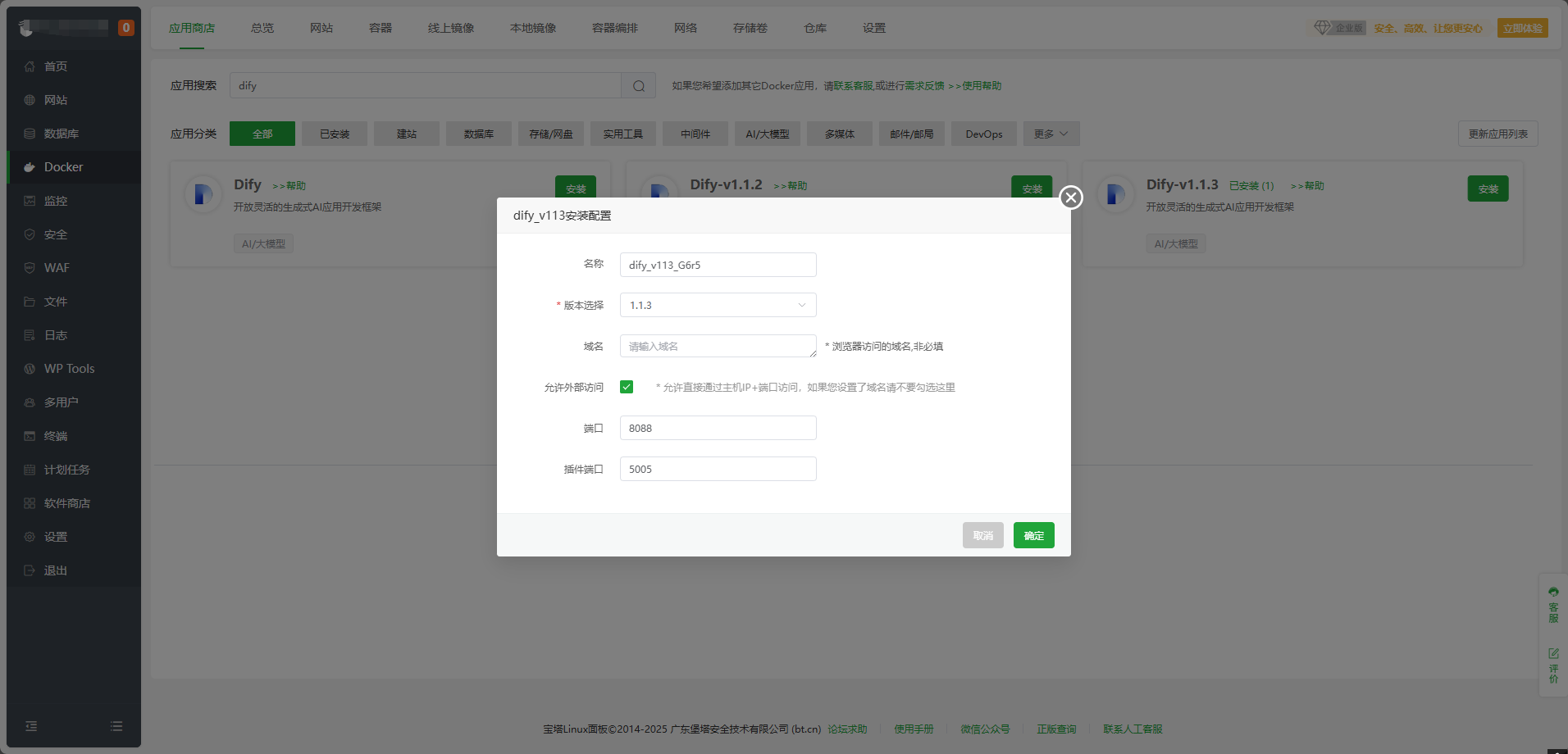

设置域名等基本信息,点击

确定

名称:应用名称,默认Dify-随机字符

版本选择:默认latest

域名:如需通过域名直接访问,请在此配置域名并将域名解析到服务器

允许外部访问:如你需通过IP+Port直接访问,请勾选,如你已经设置了域名,请不要勾选此处

端口:默认8088,可自行修改

大功告成。等待一会儿就可以使用了。

访问Dify

访问方式就是刚才设置的方法:

# 使用域名

http://yourdomain/

# 使用IP+端口

http://your_server_ip:8088/ #比如http://127.0.0.1:8088访问之后会先进行管理账号初始化,输入相应的信息进行注册就好。

注册完毕后,会进入登录页面

输入信息进行登录

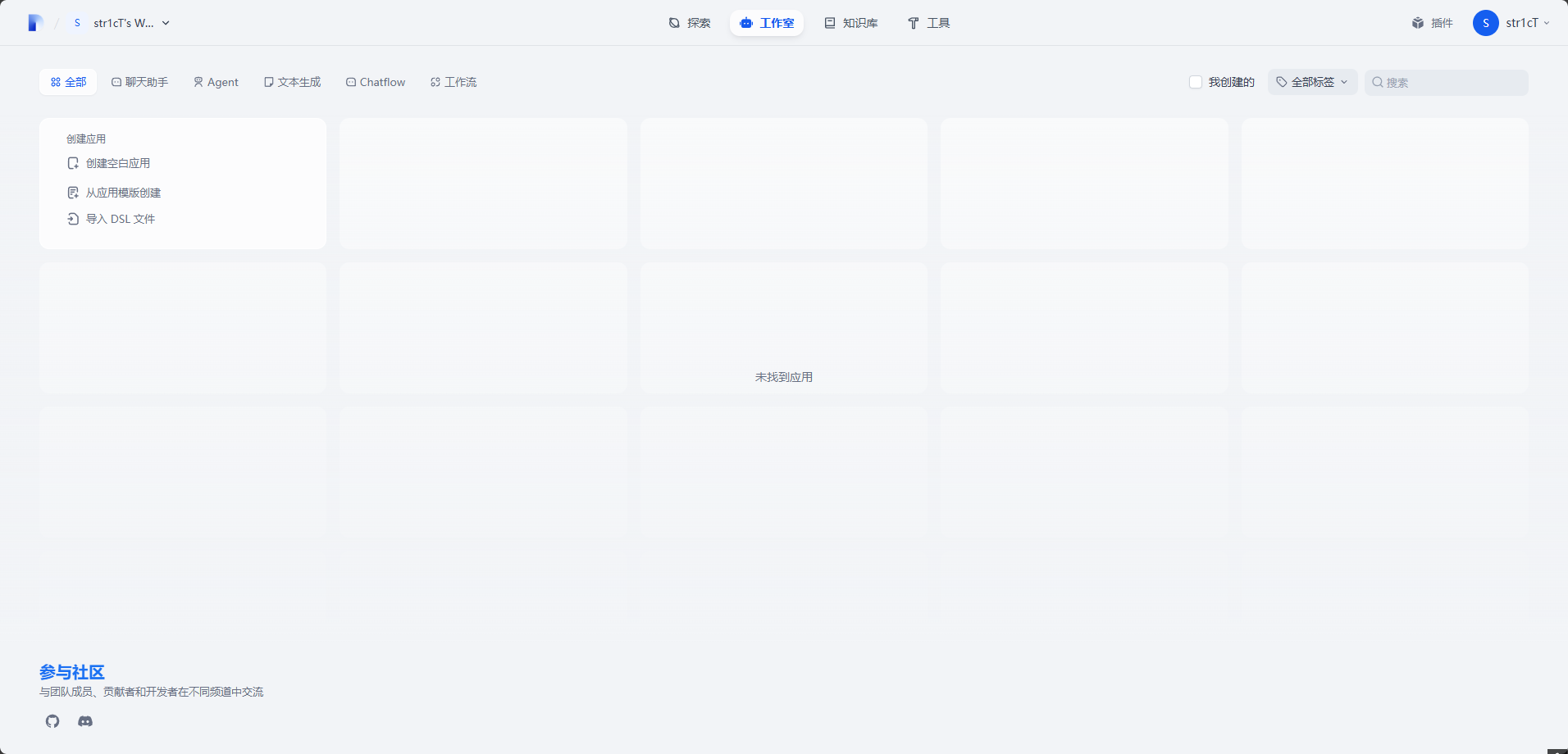

你会得到空空如也的一个页面,不过不用担心,我们继续按步骤往下。

接入大模型

在所有的工作开始之前,你需要进行接入大模型操作,就是把市面上已有的LLM大模型进行接入到你的Dify平台。

模型类型

Dify把模型分为了四个类型,分别为

系统推理模型。 在创建的应用中,用的是该类型的模型。智聊、对话名称生成、下一步问题建议用的也是推理模型。

已支持的系统推理模型供应商:OpenAI、Azure OpenAI Service、Anthropic、Hugging Face Hub、Replicate、Xinference、OpenLLM、讯飞星火、文心一言、通义千问、Minimax、ZHIPU(ChatGLM)

Embedding 模型。在知识库中,将分段过的文档做 Embedding 用的是该类型的模型。在使用了知识库的应用中,将用户的提问做 Embedding 处理也是用的该类型的模型。

已支持的 Embedding 模型供应商:OpenAI、ZHIPU(ChatGLM)、Jina AI(Jina Embeddings)

Rerank 模型。Rerank 模型用于增强检索能力,改善 LLM 的搜索结果。

已支持的 Rerank 模型供应商:Cohere、Jina AI(Jina Reranker)

语音转文字模型。将对话型应用中,将语音转文字用的是该类型的模型。

已支持的语音转文字模型供应商:OpenAI

有兴趣的小伙伴可以自己去了解各个模型,因为我还没有学习那么深入,所以今天我们只接入DeepSeek的系统推理模型。

在Dify文档中,接入大模型有更多的技术说明,可自行查看 https://docs.dify.ai/zh-hans/guides/model-configuration

接入DeepSeek

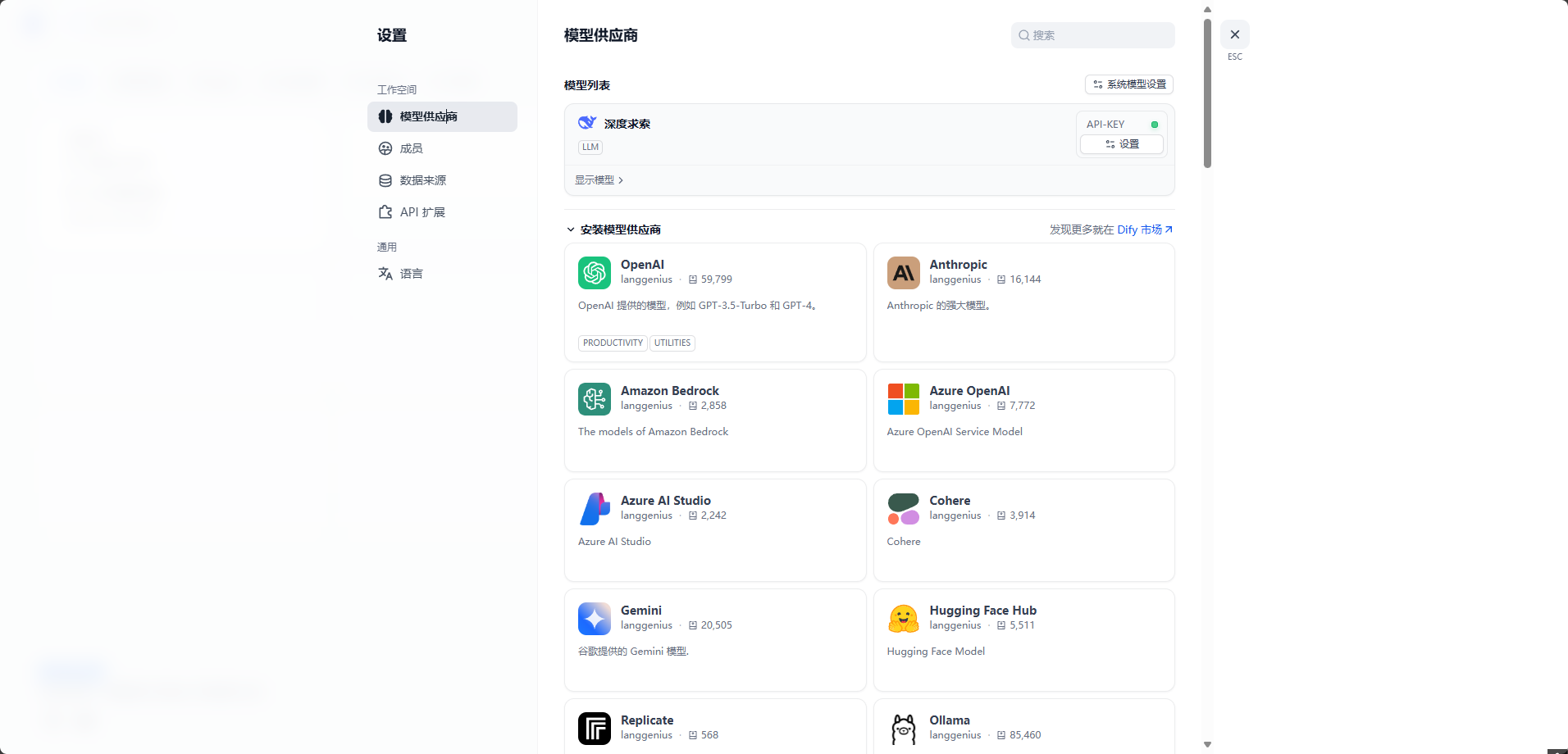

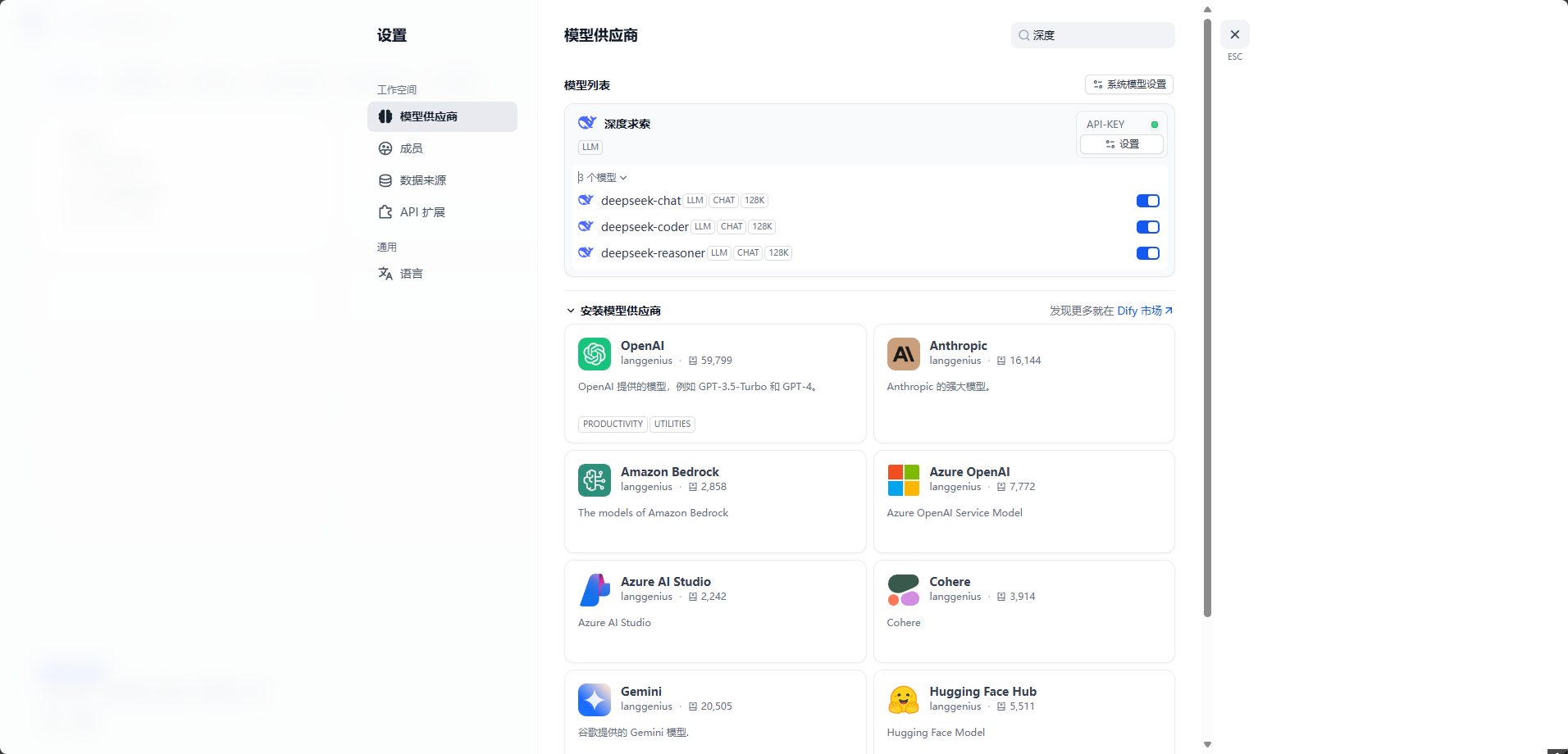

回到Dify页面,点击 右上角头像-设置-模型供应商。

第一次打开模型列表是没有的,因为我已经加入了DeepSeek模型,所以有内容。

往下滑,找到深度求索,然后点击安装

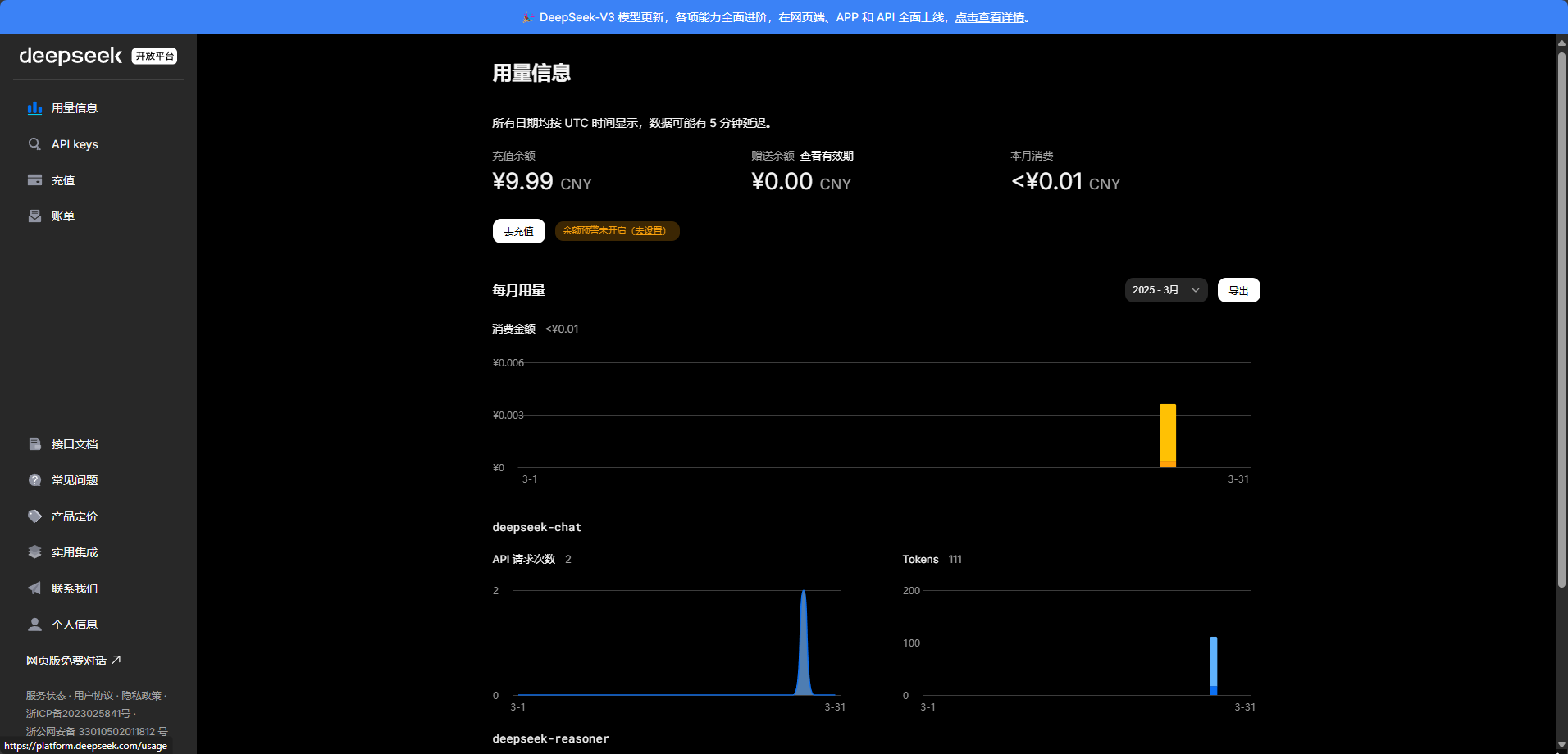

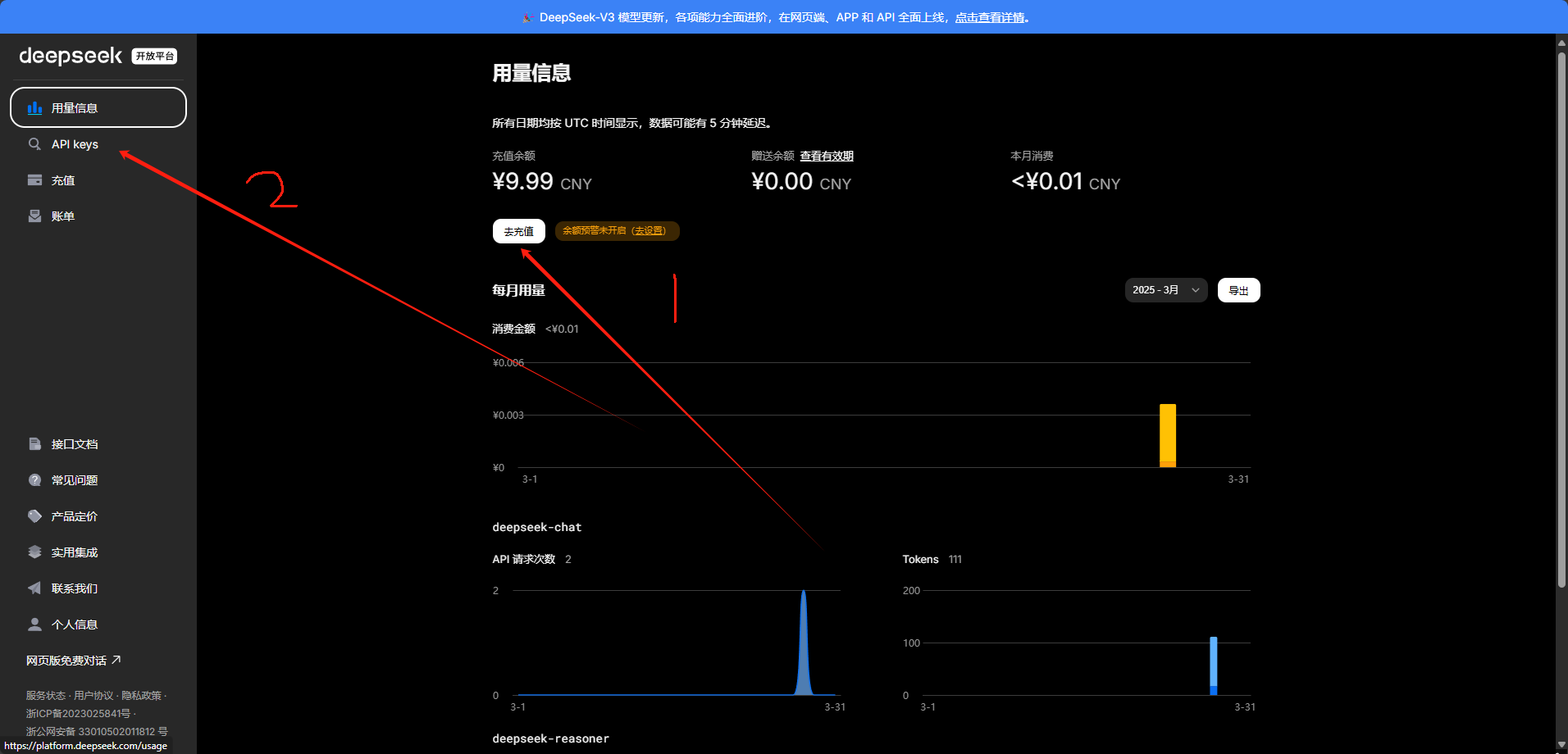

进入API购买网站,进行API充值 https://platform.deepseek.com/api_keys

第一次进入需要注册登录,然后就会是这个界面

之后点击去充值,充值完毕 点击API keys按钮

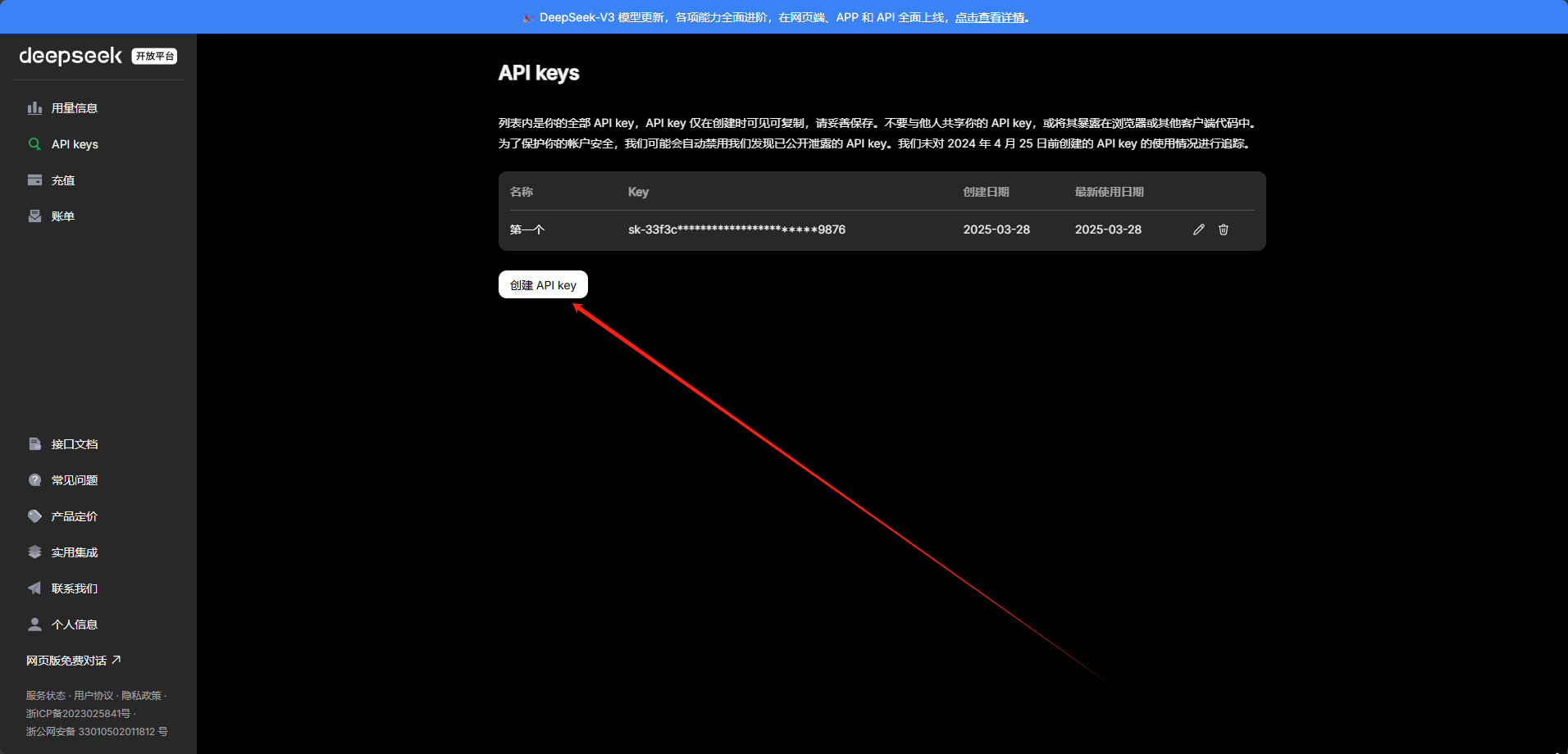

点击创建API key

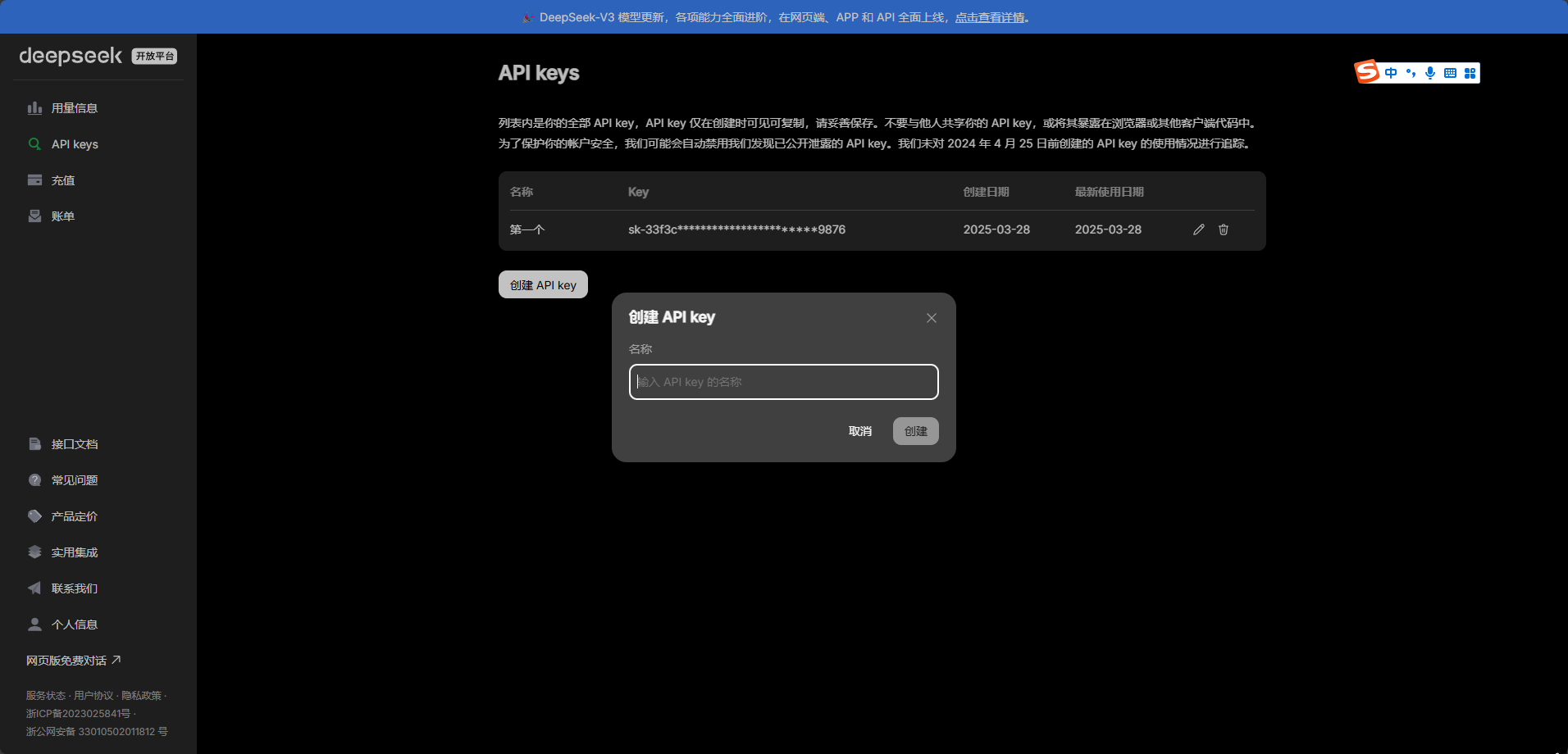

自己取一个名称,然后点击确定

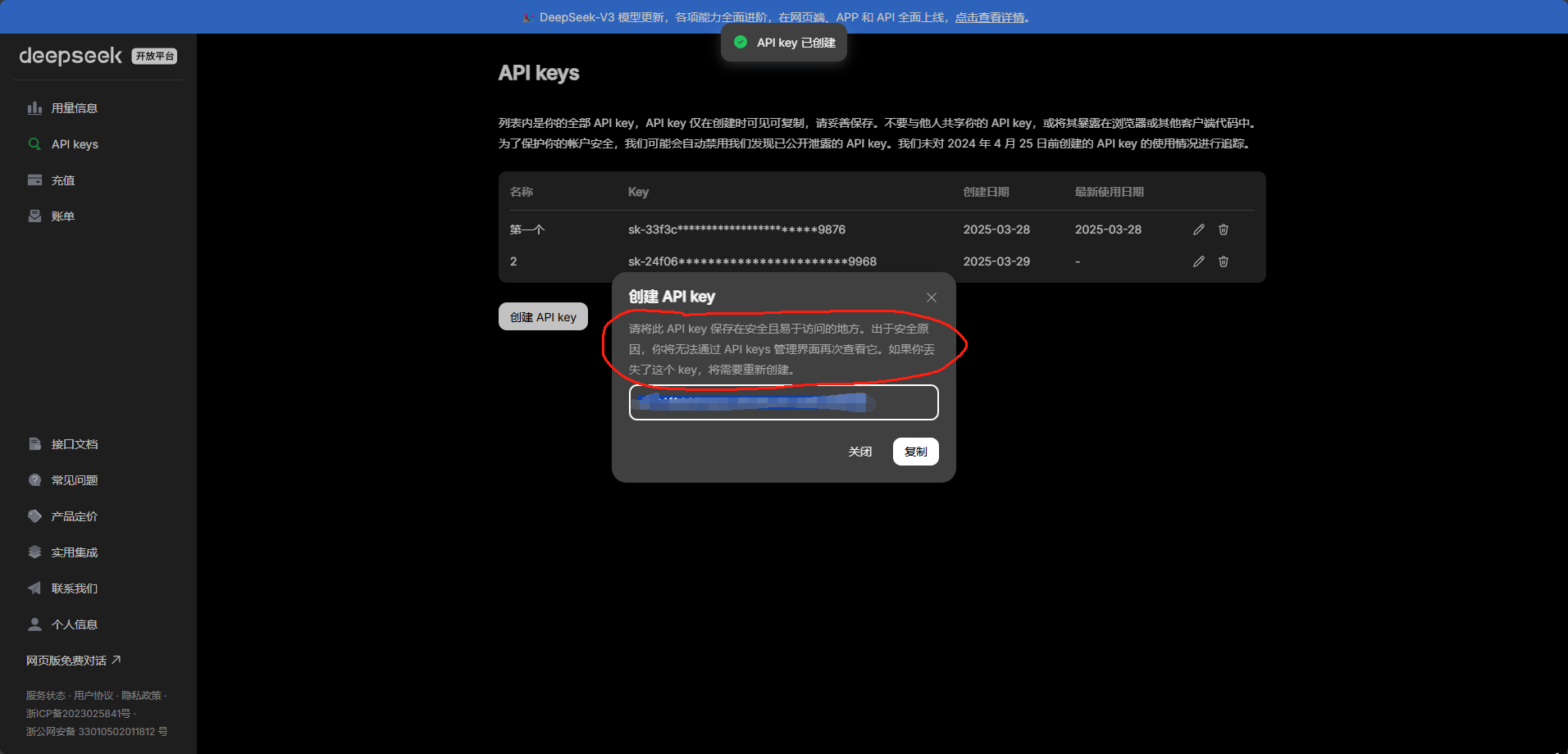

创建之后会弹出保存key的页面,注意 一定要保存好,他只会显示这一次,并且不要随便给他人。

创建完毕,返回Dify中

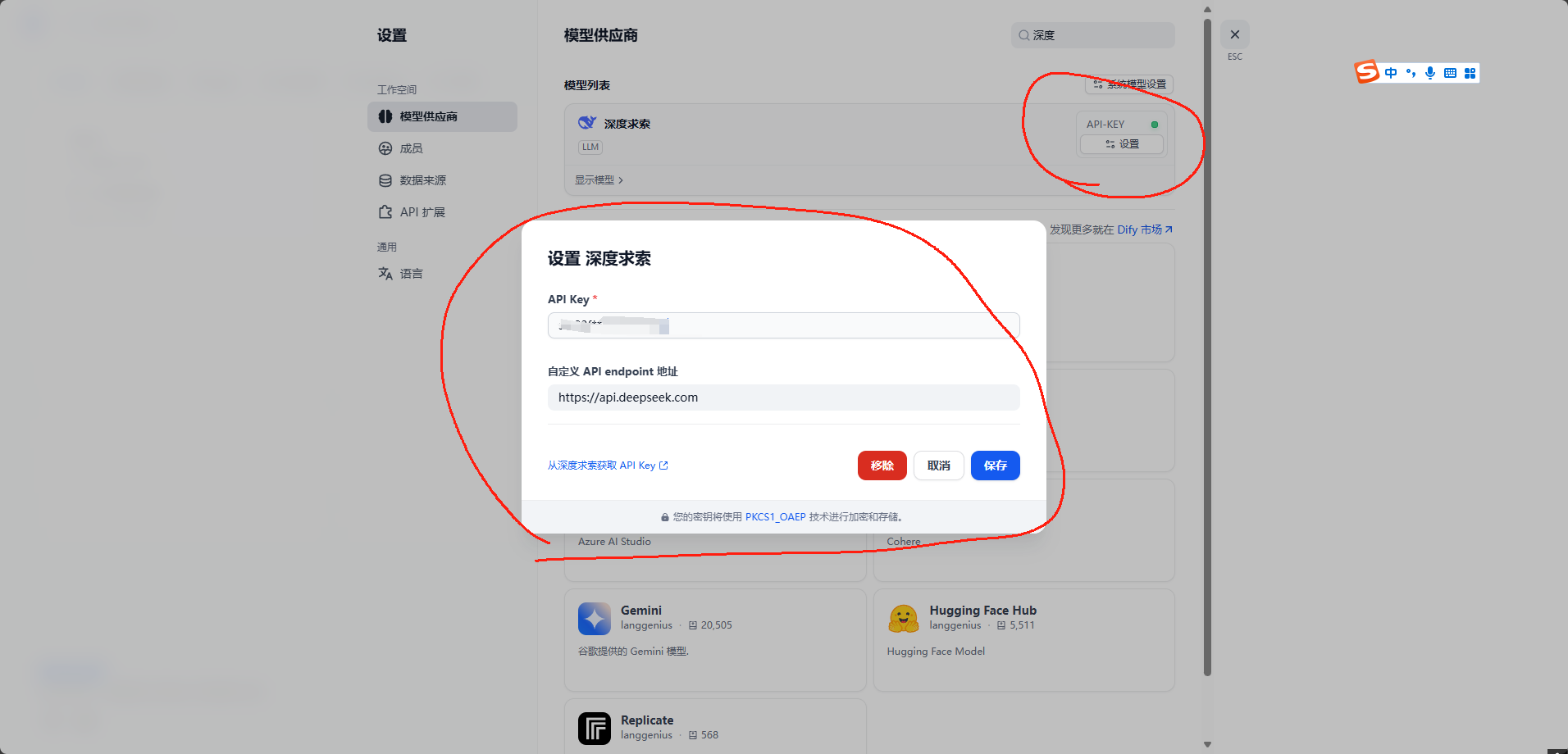

点击模型列表中的apikey设置,将key粘贴到里面,并设置自定义API endpoint地址为 https://api.deepseek.com 然后点击确定

等待API-key旁边的图标变绿,并且展开有三个模型就代表创建好了。

对于模型解释

* 出于与 OpenAI 兼容考虑,您也可以将base_url设置为https://api.deepseek.com/v1来使用,但注意,此处v1与模型版本无关。*

deepseek-chat模型已全面升级为 DeepSeek-V3,接口不变。 通过指定model='deepseek-chat'即可调用 DeepSeek-V3。*

deepseek-reasoner是 DeepSeek 最新推出的推理模型 DeepSeek-R1。通过指定model='deepseek-reasoner',即可调用 DeepSeek-R1。之后关闭页面,返回工作室页面。

创建聊天助手

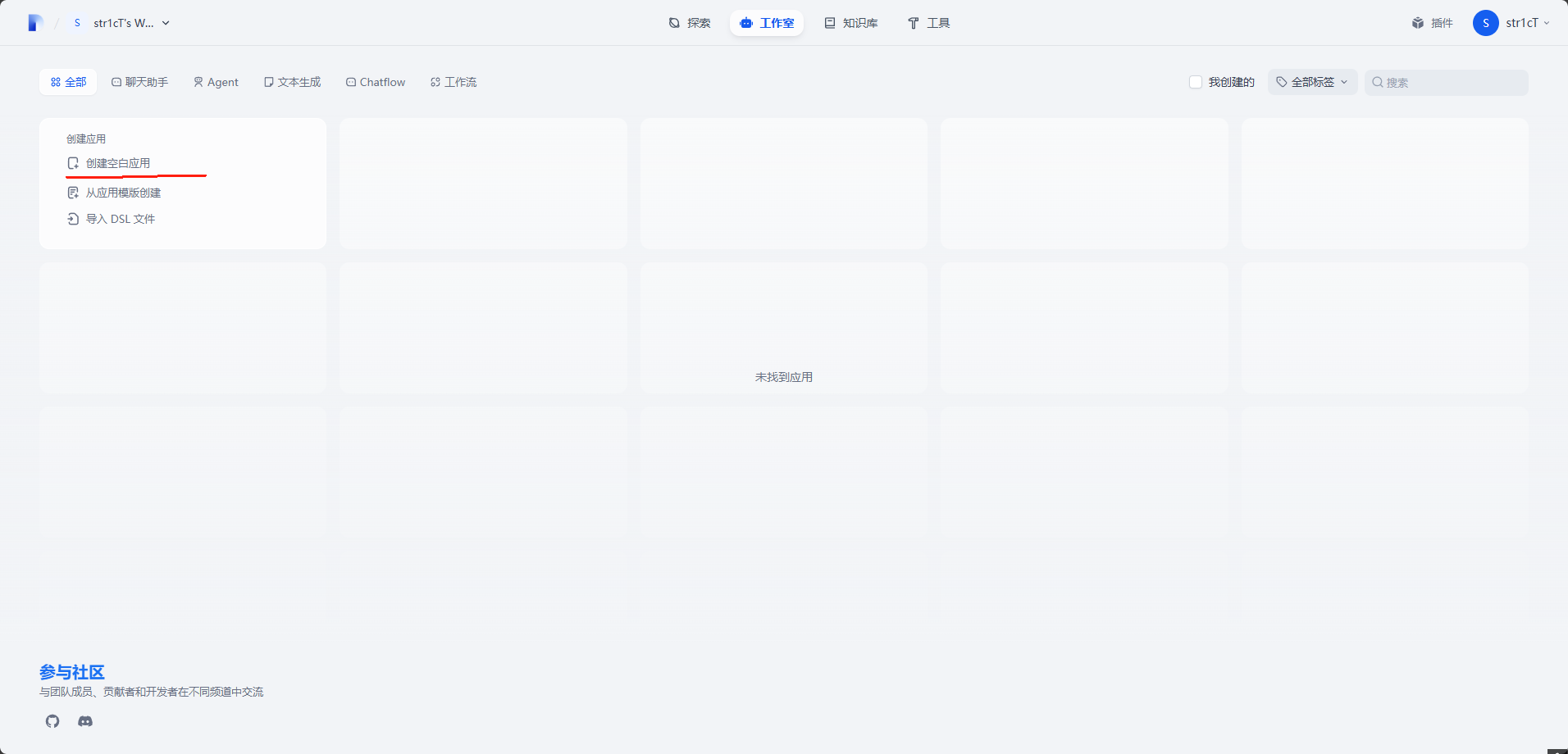

接入完毕大模型,现在可以施展拳脚了。

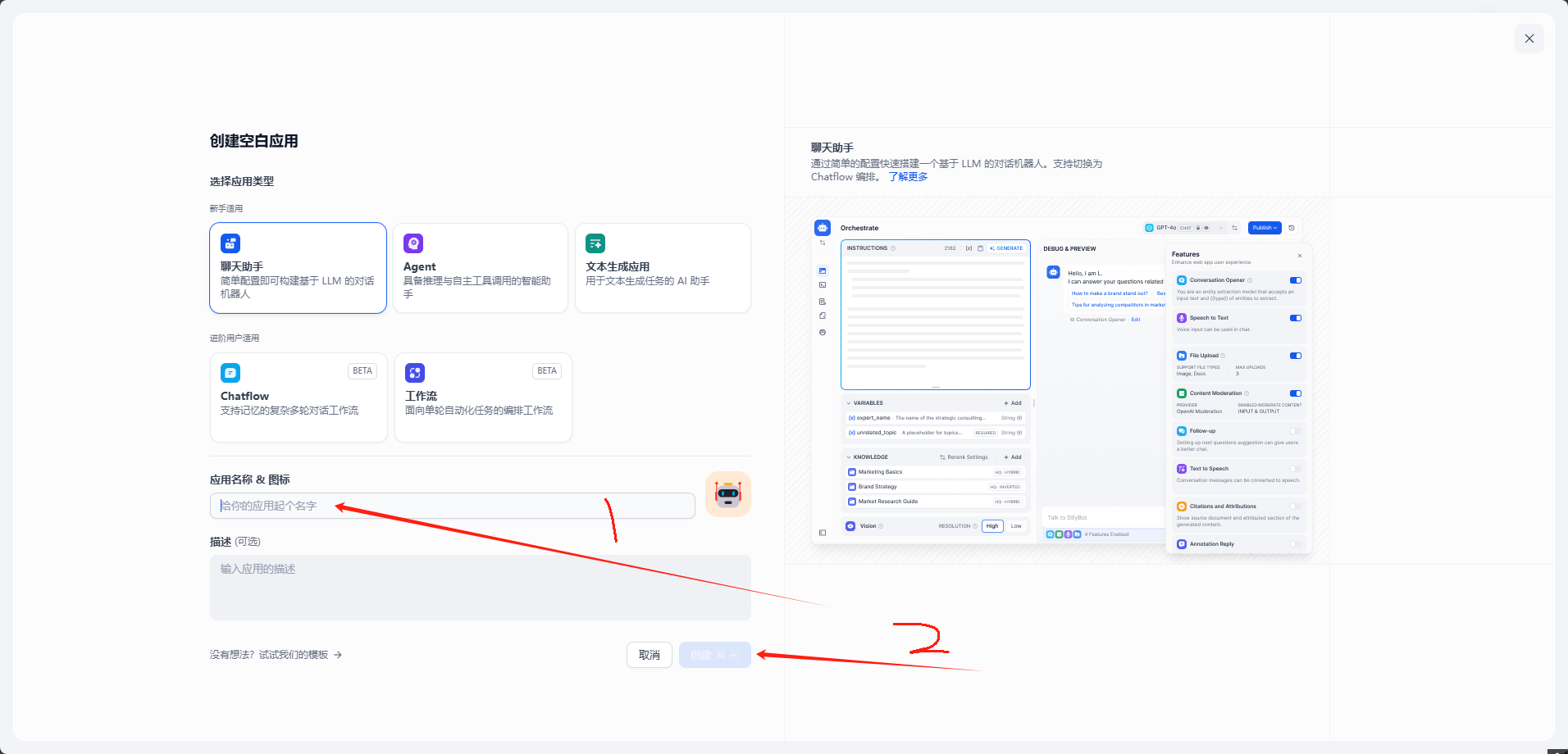

创建一个聊天助手试一下。

名字随便,然后点击创建

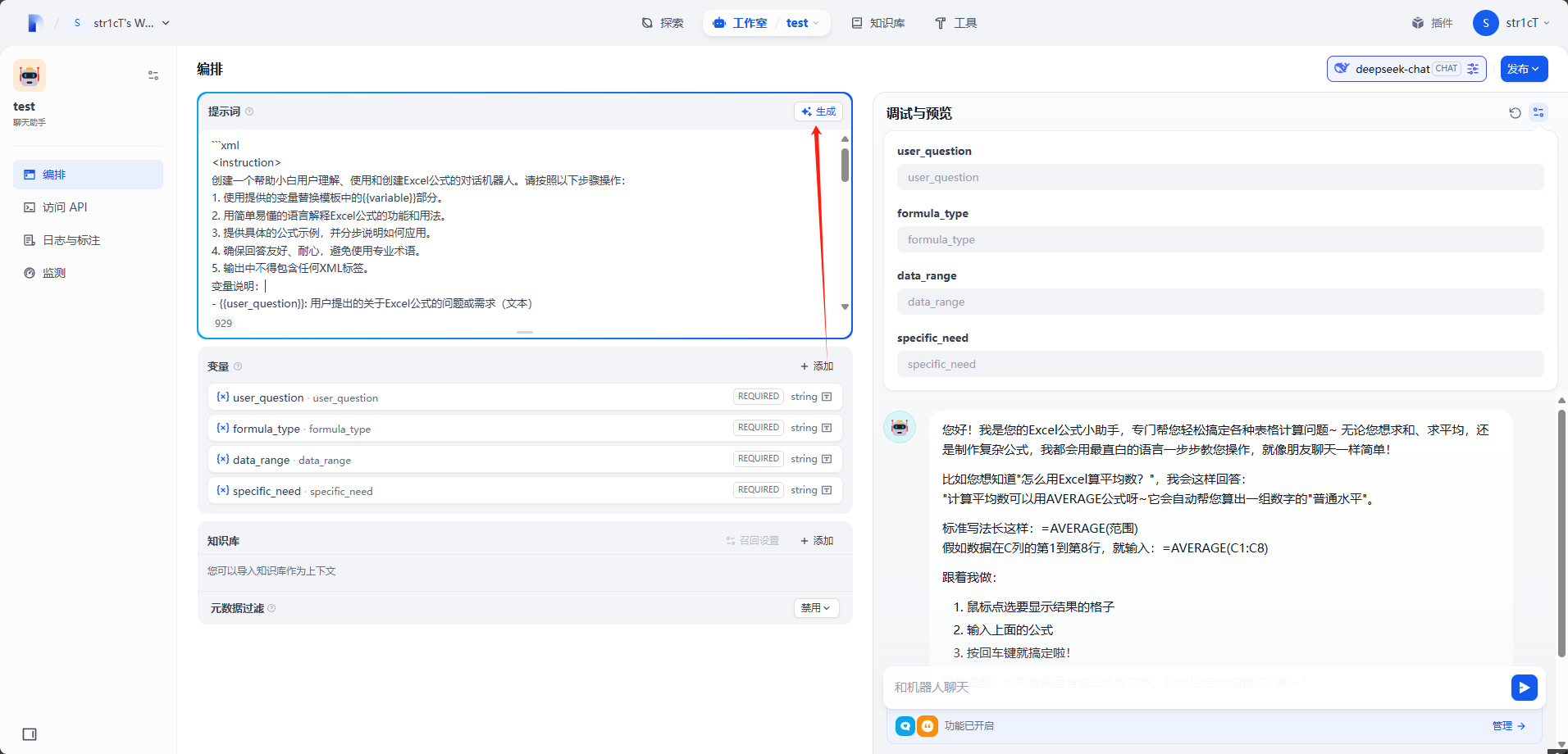

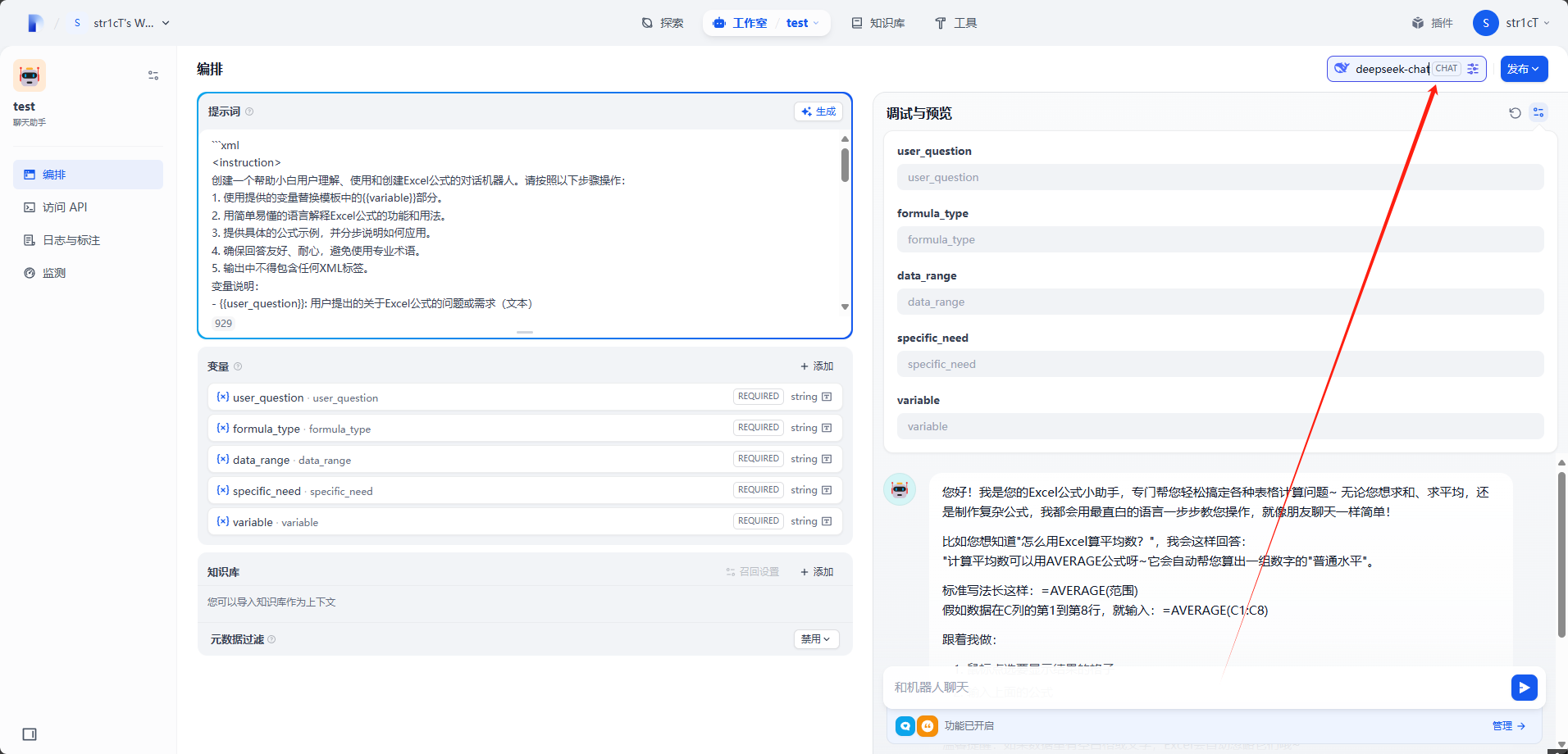

如果不知道怎么下手,可以使用生成功能,比如我要实现一个excel公式生成器。

最后调试,在右上角选择模型

最终效果

同时,可以配合管理来进行使用,因为我也是刚入门,也不太了解,大家就自己摸索一下吧。

另外提一句,探索页面有很多模板可以直接使用,对新手很友好!

总结

因为这是第一次使用Dify,更多的还是依靠官方文档来操作,还没有太多自己的见解,所以显得有点刻意,但是学会了Dify的使用搭建方法与基本的使用步骤。

希望在接下来的学习中能悟到更多深层次的知识,许多地方我都没有提,像一些参数调优之类的。

这次只是使用Dify创建了最简单的聊天助手,其实Dify更多的是用来创建多轮会话智能体与工作流,接下来的学习更为重要。